Яндекс разработал решение, которое позволит бизнесу сократить расходы на внедрение нейросетей до восьми раз

Команда Yandex Research вместе с IST Austria и KAUST разработала и опубликовала в свободном доступе новые методы сжатия больших языковых моделей. Эти методы помогут бизнесу уменьшить затраты на вычислительные ресурсы до восьми раз. Решение будет полезно корпорациям, стартапам и исследователям, работающим с нейросетями на собственном оборудовании.

Для обеспечения качественных и быстрых ответов от больших языковых моделей обычно требуется множество дорогостоящих мощных графических процессоров. Решение, предложенное Яндексом, помогает уменьшить модель в несколько раз и сократить число необходимых для работы процессоров, обеспечить запуск модели на устройствах с меньшей вычислительной мощностью.

Решение включает 2 инструмента. Первый инструмент снижает объем нейросети до восьми раз. Второй – исправляет ошибки, возникающие при сжатии большой языковой модели.

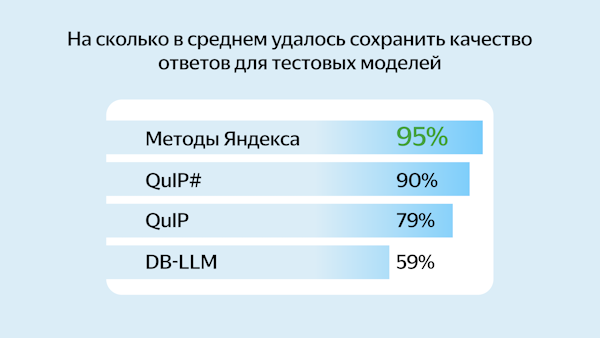

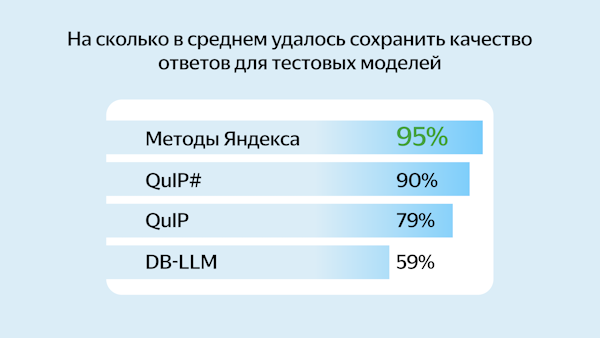

Эффективность методов сжатия нейросетей оценивали на популярных моделях с открытым исходным кодом: Llama 2, Llama 3, Mistral и других. Метод Яндекса сохраняет в среднем 95% качества ответов нейросети, тогда как другие популярные инструменты сохраняют для тех же моделей от 59% до 90% качества.

Новые методы сжатия нейросетей доступны для применения – код опубликован на GitHub. Также исследователи Yandex Research выложили обучающие материалы, которые помогут разработчикам дообучить уменьшенные нейросети под свои сценарии.

Напомним, ранее Т-Банк открыл разработчикам доступ к своей языковой модели T-lite.

Источник: пресс-релиз Яндекса

Комментарии закрыты.